Zastosowanie permutacji i kombinacji w algorytmach komputerowych

Permutacje i kombinacje stanowią fundament wielu algorytmów komputerowych, szczególnie w dziedzinach takich jak algorytmy optymalizacyjne, przetwarzanie danych, sztuczna inteligencja czy kryptografia. Zastosowanie permutacji w algorytmach często wiąże się z generowaniem wszystkich możliwych układów elementów — co jest kluczowe na przykład w sortowaniu, analizie grafów czy przeszukiwaniu przestrzeni rozwiązań. Przykładem może być algorytm brute force rozwiązujący problem komiwojażera, który testuje wszystkie permutacje tras w celu znalezienia tej optymalnej. Z kolei kombinacje wykorzystuje się w algorytmach selekcji cech w uczeniu maszynowym, gdzie konieczne bywa sprawdzenie wszystkich możliwych podzbiorów cech w celu wyboru najlepszego zestawu predyktorów. Dzięki zastosowaniu kombinacji można efektywnie generować zestawy zmiennych wejściowych przy ograniczeniach zasobów obliczeniowych. W praktyce obliczeniowej wykorzystuje się również zoptymalizowane algorytmy do generowania kombinacji i permutacji bez potrzeby przechowywania wszystkich możliwych wyników w pamięci — co jest szczególnie istotne w zadaniach wymagających wysokiej wydajności. Permutacje i kombinacje w algorytmach komputerowych odgrywają zatem niezwykle ważną rolę, umożliwiając rozwiązywanie skomplikowanych problemów w sposób systematyczny i przewidywalny, co ma bezpośrednie przełożenie na efektywność rozwiązań informatycznych w praktyce.

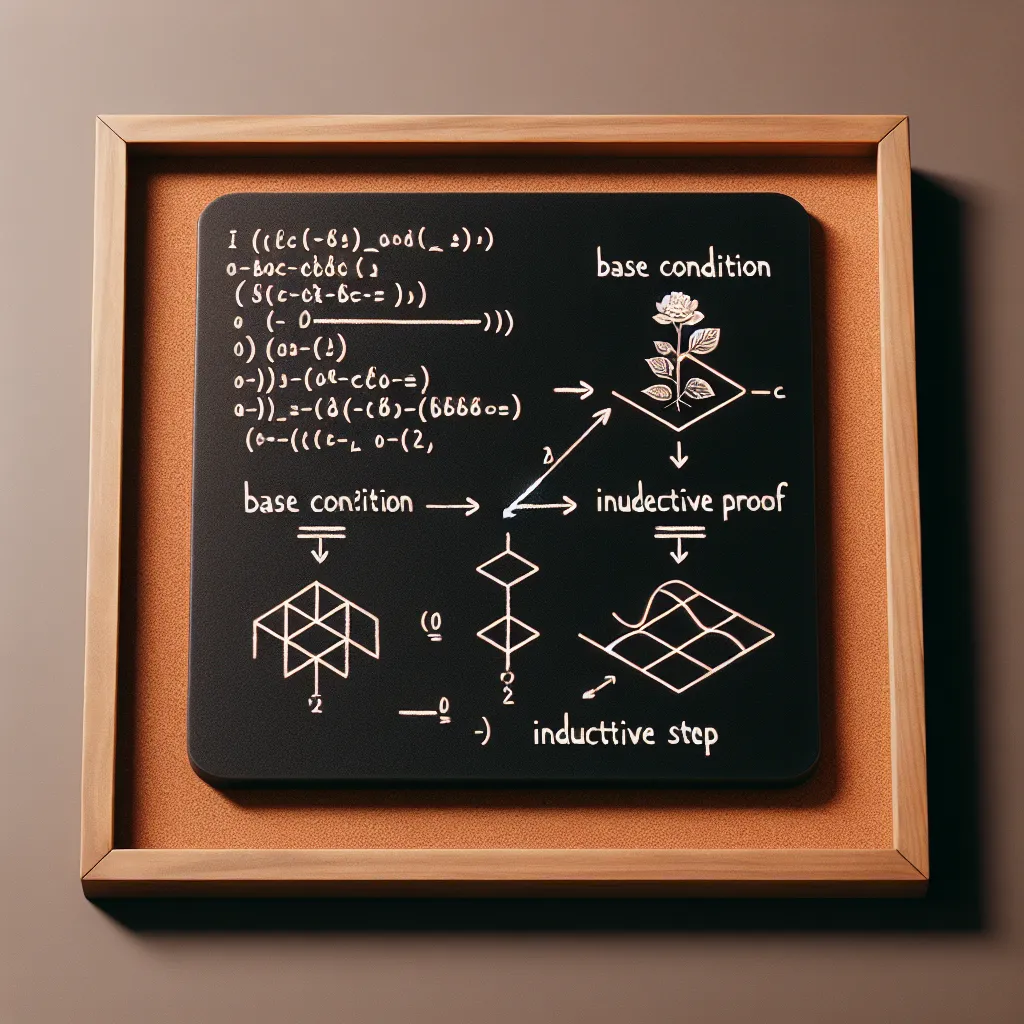

Permutacje vs kombinacje – kluczowe różnice i przykłady zastosowań

Permutacje vs kombinacje – zrozumienie kluczowych różnic między tymi dwoma pojęciami jest niezbędne w praktycznej analizie danych, statystyce oraz programowaniu. Choć oba zagadnienia dotyczą wyboru elementów z większego zbioru, różnią się istotnie pod względem uwzględnienia kolejności. W przypadku permutacji kolejność elementów MA znaczenie – inaczej mówiąc, ułożenie „ABC” różni się od „CBA”. Natomiast w kombinacjach kolejność NIE MA znaczenia, czyli „ABC”, „BAC” i „CBA” traktujemy jako jeden ten sam wybór.

Permutacje znajdują szerokie zastosowanie wszędzie tam, gdzie istotna jest kolejność – na przykład przy planowaniu harmonogramu zadań, układaniu szyfrów czy generowaniu możliwych haseł w testach bezpieczeństwa. Praktyczny przykład? Obliczenie liczby możliwych miejsc medalowych (złoto, srebro, brąz) dla trzech najlepszych sportowców spośród dziesięciu to klasyczny przypadek permutacji, ponieważ miejsce na podium ma znaczenie.

Z kolei kombinacje są użyteczne przy analizie koszyka zakupowego, projektowaniu badań statystycznych (np. dobór losowej próby), a nawet w biologii w kontekście możliwych zestawień genów. Przykład praktyczny? Jeśli z grupy 10 osób chcemy wybrać 3 do zespołu projektowego, gdzie każdy ma równe prawa i nie ma podziału na funkcje – mamy do czynienia z kombinacją.

Rozróżnienie pomiędzy permutacjami a kombinacjami jest kluczowe nie tylko w teorii, ale przede wszystkim w praktyce obliczeniowej. Źle zdefiniowany problem może doprowadzić do błędnych wyników obliczeń, zwłaszcza w analizie danych czy algorytmice. Dlatego znajomość tych pojęć oraz świadomy wybór odpowiedniego podejścia jest fundamentalny dla każdego, kto projektuje systemy oparte na danych, statystyce lub kombinatoryce.

Optymalizacja zadań przy użyciu kombinatoryki

Optymalizacja zadań przy użyciu kombinatoryki to jedno z kluczowych zastosowań permutacji i kombinacji w praktyce obliczeniowej. W wielu dziedzinach informatyki, takich jak sztuczna inteligencja, badania operacyjne, czy analiza algorytmów, optymalizacja polega na znalezieniu najlepszego możliwego rozwiązania spośród ogromnej liczby wariantów. Permutacje i kombinacje pozwalają nie tylko oszacować liczbę takich rozwiązań, ale również zaprojektować efektywne algorytmy eksplorujące wybrane przypadki.

Na przykład, w problemach typu komiwojażera, gdzie celem jest znalezienie najkrótszej trasy odwiedzającej wszystkie punkty tylko raz, wykorzystuje się permutacje możliwych tras. Choć liczba permutacji rośnie wykładniczo, dzięki metodom kombinatorycznym oraz technikom takim jak programowanie dynamiczne, heurystyka czy przeszukiwanie z nawrotem (backtracking), można zredukować liczbę sprawdzanych przypadków i przyspieszyć obliczenia.

Podobne podejście stosuje się w automatycznym planowaniu zadań czy optymalizacji harmonogramów, gdzie kombinacje możliwych przypisań zasobów muszą zostać przeanalizowane w celu zminimalizowania kosztów lub czasu realizacji. Kluczowe znaczenie mają tu pojęcia permutacji bez powtórzeń, kombinacji z powtórzeniami oraz funkcje generujące, które pozwalają na modelowanie i analizę rozwiązań w sposób matematycznie precyzyjny i obliczeniowo efektywny.

W praktyce, optymalizacja zadań przy użyciu kombinatoryki pozwala znacząco zwiększyć wydajność systemów obliczeniowych, umożliwiając np. szybsze przetwarzanie danych, bardziej efektywne zarządzanie zasobami oraz lepszą adaptację do zmieniających się warunków. Stąd rosnące zainteresowanie inżynierów i naukowców zagadnieniami związanymi z kombinatoryką, permutacjami i kombinacjami oraz algorytmami je wykorzystującymi.

Rola permutacji w generowaniu danych testowych i losowych próbek

Permutacje odgrywają kluczową rolę w generowaniu danych testowych oraz losowych próbek, szczególnie w dziedzinach takich jak testowanie oprogramowania, analiza statystyczna czy badania naukowe. Dzięki nim możliwe jest tworzenie zbiorów danych, które odzwierciedlają różnorodne warianty sytuacji, zapewniając pełniejsze pokrycie testowego środowiska. Generowanie permutacji umożliwia symulację wszystkich możliwych układów elementów w zestawie danych, co ma zasadnicze znaczenie podczas testowania algorytmów, szczególnie tych wrażliwych na kolejność danych wejściowych. W praktyce obliczeniowej, permutacje są często wykorzystywane do generowania danych testowych, które pomagają wykrywać błędy w działaniu systemów, a także służą do tworzenia losowych próbek, które zapewniają statystycznie reprezentatywne wyniki eksperymentów.

W kontekście generowania losowych próbek, permutacje zapewniają element nieprzewidywalności i różnorodności, eliminując ryzyko systematycznych błędów wynikających z nieprzemyślanego doboru danych. W szczególności, w analizie Monte Carlo i metodach bootstrapowania, kluczowe jest tworzenie wielu losowych permutacji danych w celu uzyskania estymatorów parametrów z odpowiednim poziomem niepewności. Dzięki zastosowaniu algorytmów takich jak Fisher-Yates shuffle (znany również jako Knuth shuffle), programiści mogą szybko wygenerować losowe permutacje, które stanowią solidny fundament pod dalsze testy jakościowe i ilościowe. W praktyce, efektywne wykorzystanie permutacji znacząco zwiększa wiarygodność i kompleksowość testów, co przekłada się na lepszą jakość końcowego produktu lub rzetelność wyników badań.